Адрес для входа в РФ: exler.world

Какие ваши видеодоказательства?

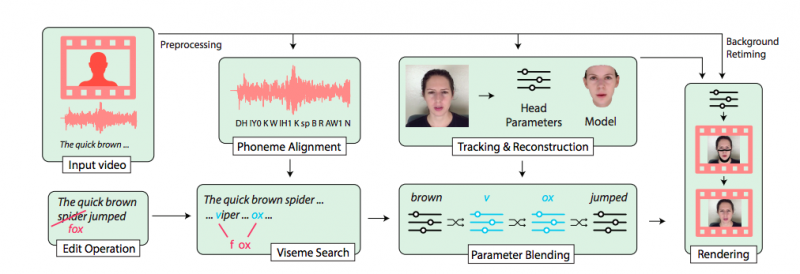

Исследователи из Стэнфордского и Принстонского университетов создали алгоритм, который искажает речь человека на видео. Для убедительности программа не только подстраивает голос, но и изменяет мимику, а также длину ролика.

Как рассказали разработчики, устроена их программа так: из ролика она выделяет аудиодорожку, разделяя речь человека на фонемы. Далее ПО создает 3D модель лица человека, сканируя, как он двигает губами, произнося слова. Затем машина находит висемы — звуки, которые выглядят одинаково при движении губ — и использует их для создания мимики под новые фразы. В итоге из двух произнесенных слов алгоритм создает третье.

Чтобы отредактированный голос больше походил на речь модели, исследователи пользуются программой VoCo, которую они представили в 2016 году. Проанализировав небольшой монолог человека, она способна «спародировать» его голос.

В ознакомительном ролике исследователи показали демоверсию разработки. Например, одного диктора они «заставили» говорить French toast вместо Napalm в предложении I love the smell of napalm in the morning. Другого диктора и вовсе лишили одного слова — программа также умеет удалять речь из ролика. (Отсюда.)

М-да... Deep Fake может на видео заменить лицо человека на другое. Эта программа может заставить человека говорить то, чего он не говорил.

Ну и как после этого верить каким-то видеодоказательствам?

The Wall Street Journal рассказал об интересном случае: мошенники использовали голосовой deepfake, чтобы во время телефонного разговора выдать себя за руководителя неназванной немецкой фирмы. По телефону фиктивный CEO, чей голос был подделан при помощи ИИ, попросил главу неназванной дочерней фирмы из Британии срочно перевести 220 000 евро на счет некоего венгерского поставщика, хотя на самом деле этот счет принадлежал преступникам.

Правда, этим должны будут озаботиться все производители видеозаписывающих устройств (от камер до телефонов). Поэтому – да, сложновато...

А я про то, чтобы, грубо говоря, подписывать каждый кадр хэшем его же собственных параметров (зональные распределения яркости/цвета, временное/амплитудное распределение звука, и т.д.) прямо в процессе съёмки – для надёжной верификации.

Если в этих параметрах изменится хоть один бит, то при проверке кадр автоматически определится как "подозрительный" (то есть, в качестве "стопроцентного доказательства" видео с такими кадрами использовано быть уже не может).

То есть, при должном умении – может получиться штуковина надёжнее даже аппаратных рандомайзеров...

ИМХО, сейчас, с появлением всяких "рисующих нейро-приблуд" – индустрии пора озаботиться фактором "достоверности" совершенно всерьёз, как никогда раньше...

А Эрнст уже качает программу с торрентов.